1、爬行与抓取(crawling & indexing)爬行:搜索引擎使用自动程序,通常称为“爬虫”或“蜘蛛”(如google的googlebot),它们通过跟踪网页上的超链接在网络中不断发现新的网页和更新内容。

2、搜索引擎的原理是数据收集、建立索引数据库、索引数据库中搜索和排序。搜索引擎的自动信息收集功能分为两种类型,一种是定期搜索,即每隔一段时间,搜索引擎就会主动发送一个“蜘蛛”程序来搜索特定IP地址范围内的互联网站点。

3、搜索引擎的工作过程是一个复杂的过程,通常包括以下步骤: **抓取(Crawling)**:搜索引擎会使用自动化的程序,称为网络爬虫或蜘蛛,来浏览互联网上的网页。

4、在数字世界里,搜索引擎是我们探索信息的得力助手。根据其工作方式,搜索引擎主要可以分为三大类:全文搜索引擎、目录索引类搜索引擎以及元搜索引擎。本文将为您详细介绍这三种搜索引擎的工作原理。

5、搜索策略主要有以下几种: 关键词搜索:这是最常见的搜索策略,用户通过在搜索引擎中输入关键词或短语来寻找相关信息。搜索引擎会根据这些关键词在其索引中找到相关的结果。

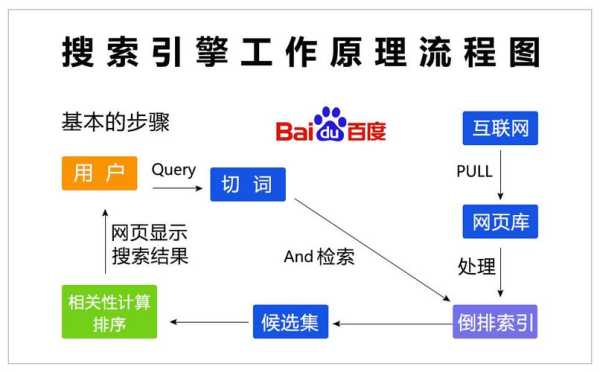

6、百度搜索的工作原理是一个复杂而精细的系统,它涉及到多个领域的知识和技能,包括计算机科学、数学、统计学、语言学、信息学等等。 那么百度搜索是全球最大的中文搜索引擎,每天响应数十亿次搜索请求。

索引 索引就是帮助程序进行快速查找的。大家都用过英汉词典。字典前边的按照单词首字母排列的部分就是索引。搜索引擎也一样。这里要介绍第一个最重要的数据结构:反转列表。

搜索引擎的工作过程是一个复杂的过程,通常包括以下步骤: **抓取(Crawling)**:搜索引擎会使用自动化的程序,称为网络爬虫或蜘蛛,来浏览互联网上的网页。

搜索引擎的工作过程,一般分为五个步骤:(1)从互联网上抓取网页,利用能够从互联网上自动收集网页的网络蜘蛛程序,自动访问互联网,并沿着任何网页中的所有URL爬到其它网页,重复这过程,并把爬过的所有网页收集回来。

搜索引擎的工作原理主要就是四个步骤:爬行,抓取,检索,显示。

网页抓取 Spider每遇到一个新文档,都要搜索其页面的链接网页。搜索引擎蜘蛛访问web页面的过程类似普通用户使用浏览器访问其页面,即B/S模式。

1、搜索引擎的4个组成部分包括爬虫、索引器、排序算法和搜索器,其各部分的主要功用如下:爬虫(Spider):也被称为机器人或网页蜘蛛,负责在互联网上抓取和收集网页信息。

2、搜索器、索引器、检索器和用户接口。搜索引擎由搜索器、索引器、检索器和用户接口四个部分组成,所谓搜索引擎,就是根据用户需求与一定算法,运用特定策略从互联网检索出指定信息反馈给用户的一门检索技术。

3、该组成部分是爬虫、索引、检索与排名和用户界面。爬虫或蜘蛛:这是搜索引擎的基础,负责在互联网上抓取和收集信息。索引:索引是将抓取到的网页信息进行组织和管理的方式。

4、组成:搜索引擎一般由搜索器、索引器、检索器和用户接口四个部分组成 原理:使用自动索引软件(搜索器,也称“网络机器人”或“网络蜘蛛”)来搜集和标记网页资源,并将这些资源存入数据库。

5、搜索引擎大致由搜索系统、索引系统、检索系统三个部分组成。爬虫(Spider)或网络蜘蛛:爬虫是搜索引擎的核心组成部分之一,它负责在互联网上自动抓取网页内容。

6、一个搜索引擎由搜索器 、索引器 、检索器 和用户接口 四个部分组成。搜索器的功能是在互联网 中漫游,发现和搜集信息。索引器的功能是理解搜索器所搜索的信息,从中抽取出索引项,用于表示文档 以及生成文档库的索引表。

1、信息检索程序通常包括以下步骤: 信息需求分析:首先需要明确信息检索的需求,包括需要查找的主题、关键词、领域等。 确定信息源:根据需求选择合适的信息源,例如数据库、搜索引擎、图书馆等。

2、文献检索的基本步骤包括以下步骤: 确定检索需求:明确要查找的文献类型、主题和关键词,确保在开始检索前有清晰的目标。

3、比如避免循环链接的网页;解析网页文档,提取里边的链接;当链接无法打开时对错误进行处理等。索引 索引就是帮助程序进行快速查找的。大家都用过英汉词典。字典前边的按照单词首字母排列的部分就是索引。搜索引擎也一样。

1、工作原理 抓取网页 每个独立的搜索引擎都有自己的网页抓取程序(spider)。Spider顺着网页中的超链接,连续地抓取网页。被抓取的网页被称之为网页快照。

2、百度搜索的工作原理是一个复杂而精细的系统,它涉及到多个领域的知识和技能,包括计算机科学、数学、统计学、语言学、信息学等等。 那么百度搜索是全球最大的中文搜索引擎,每天响应数十亿次搜索请求。

3、搜索引擎的工作原理总共有四步:第一步:爬行,搜索引擎是通过一种特定规律的软件跟踪网页的链接,从一个链接爬到另外一个链 接,所以称为爬行。

4、搜索引擎是一个对互联网信息资源进行搜索整理和分类,并储存在网络数据库中供用户查询的系统,包括信息搜集、信息分类、用户查询三部分。

5、它的工作原理主要是: 搜索引擎会派出蜘蛛沿着网站链接爬行到相关的网页进行抓取网页信息。将抓取到的网页信息储存到原始数据库中。

6、分类: 电脑/网络 互联网 问题描述:他是如何搜索到互连网上这么多网站的?原理是什么?解析:搜索引擎基本工作原理 了解搜索引擎的工作原理对我们日常搜索应用和网站提交推广都会有很大帮助。

1、搜索引擎对收集的信息资源进行索引,编辑摘要以形成标准页面索引,并通过数据库管理系统建立相应的索引数据库,数据库中的每条记录基本上对应于一个网页,包括关键字、网页摘要、URL地址和其他信息。

2、搜索引擎通过使用叫做蜘蛛的爬虫程序来进行抓取工作。这些网络爬虫能有效地跟踪页面之间的链接,以查找要添加到索引中的新内容。使用搜索引擎时,将从索引中提取相关结果,并使用算法对其进行排名。

3、根据其工作方式,搜索引擎主要可以分为三大类:全文搜索引擎、目录索引类搜索引擎以及元搜索引擎。本文将为您详细介绍这三种搜索引擎的工作原理。全文搜索引擎全文搜索引擎通过爬取互联网上的信息,进行整理后为用户提供查询服务。