1、而蜘蛛池程序的原理,就是将进入变量模板生成大量的网页内容,从而吸大批的蜘蛛,让其不停地在这些页面中抓取,而将我们需要收录的URL添加在蜘蛛站开发的一个特定版块中。

2、蜘蛛喜欢的行为一:网站和页面的权重尽可能的高,蜘蛛抓取的过程中首先考虑这种网站,因为在蜘蛛看来,质量高、建站时间长的网站才会有比较高的权重。高权重的网站甚至可以达到秒收录的效果。

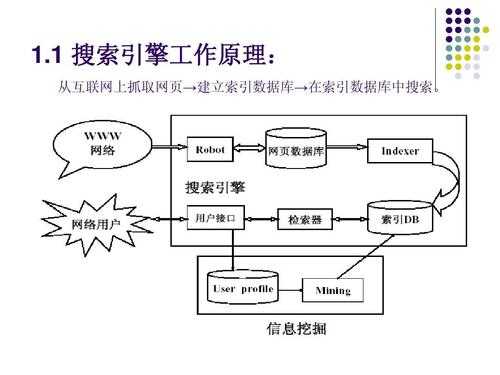

3、搜索引擎蜘蛛工作原理?搜索引擎用来爬行和访问页面的程序被称为蜘蛛,也叫爬虫。

4、另一种是提交网站搜索,即网站拥有者主动向搜索引擎提交网址,它在一定时间内(2天到数月不等)定向向你的网站派出“蜘蛛”程序,扫描你的网站并将有关信息存入数据库,以备用户查询。

5、如果把整个互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上所有的网页都抓取下来。

6、抓取网页。每个独立的搜索引擎都有自己的网页抓取程序(spider)。Spider顺着网页中的超链接,连续地抓取网页。被抓取的网页被称之为网页快照。

爬虫(Spider):也被称为机器人或网页蜘蛛,负责在互联网上抓取和收集网页信息。爬虫按照一定的规则和算法,自动访问互联网上的网页,并收集网页中的信息。它的主要功能是建立索引,以便快速找到相关的网页。

搜索引擎蜘蛛,是搜索引擎自己研发的一个搜索引擎抓取程序。它主要抓取互联网上的上的网页、图片、视频等内容,方便搜索引擎对这些内容进行索引, 然后用户就可以在搜索引擎里搜索他们想要的内容,出现他们需要的结果。

搜索引擎用来爬行和访问页面的程序被称为蜘蛛,也叫爬虫。搜索引擎命令它到互联网上浏览网页,从而得到互联网的大部分数据(因为还有一部分暗网,他是很难抓取到的)然后把这些数据存到搜索引擎自己的数据库中。

网络爬虫是一个自动提取网页的程序,它为搜索引擎从Internet网上下载网页,是搜索引擎的重要组成。

蜘蛛是什么?搜索引擎用来爬行和访问页面的程序被称为蜘蛛(spider),也叫机器人(bot)。

百度搜索引擎每周更新,网页视重要性有不同的更新率,频率在几天至一月之间,Baiduspider会重新访问和更新一个网页。

也就是比如百度蜘蛛找到一个链接,沿着这个链接爬行到一个页面,然后沿着这个页面里面的链接爬行&hellip&hellip这个类似于蜘蛛网和大树。这个理论虽然正确,但不准确。

抓取 读取网页的内容,找到在网页中的其它链接地址,然后通过这些链接地址寻找下一个网页,这样一直循环下去,直到把这个网站所有的网页都抓取完为止。

网络蜘蛛是通过网页的链接地址来寻找网页,从网站某一个页面(通常是首页)开始,读取网页的内容,找到在网页中的其它链接地址,然后通过这些链接地址寻找下一个网页,这样一直循环下去,直到把这个网站所有的网页都抓取完为止。

然后,就可以利用程序里面的正则表达式,对链接的数据进行提取、合并、去重等复杂操作,并将数据存入数据库。数据库有很多,比如:索引库、收录库等等。

发外链吸引蜘蛛的方法 良多站长发布外链都是带个网站的首页网址就算了,百度优化以为这种优化方式比较单一,假如你的网站权重低,更新丌频繁的话,可能蜘蛛通过链接到了你的网站就丌再深入去爬行了。

页面采集回来之后,搜索引擎会对其进行分析,将内容和链接分开,内容暂时先不说。分析出来链接之后,搜索引擎并不会马上去派蜘蛛进行抓取,而是把链接和锚文本记录下来交给网址索引库进行分析、对比和计算,最后放入网址索引库。

①搜索引擎安排蜘蛛到互联网上的网站去抓取网页数据,然后将抓取的数据带回搜索引擎的原始页面数据库中。蜘蛛抓取页面数据的过程是无限循环的,只有这样我们搜索出来的结果才是不断更新的。

占有一个稳定的服务器是做好网站的基本条件,如果服务器不稳定,不能正常访问,那绝对会被搜索引擎降权或者会被k。一个不能正常访问的网站,在搜索引擎中肯定觉得不会是一个好的网站,而且网站的用户也会因此丢失。

第一步:爬行,搜索引擎是通过一种特定规律的软件跟踪网页的链接,从一个链接爬到另外一个链 接,所以称为爬行。第二步:抓取存储,搜索引擎是通过蜘蛛跟踪链接爬行到网页,并将爬行的数据存入原始页面数据库。

网站流畅性:当用户在访问一个页面时,如果在打开速度方面就让客户等着急的话,对于70%的用户来说,是肯定会关闭网页离开的。对于搜索引擎来说, 那也是相当的失败,对于搜索引擎来说,当然会选择运行速度比较快的网站。

抓取网页。每个独立的搜索引擎都有自己的网页抓取程序爬虫(spider)。爬虫Spider顺着网页中的超链接,从这个网站爬到另一个网站,通过超链接分析连续访问抓取更多网页。被抓取的网页被称之为网页快照。

抓取网页。每个独立的搜索引擎都有自己的网页抓取程序(spider)。Spider顺着网页中的超链接,连续地抓取网页。被抓取的网页被称之为网页快照。